新网站建设为什么需要加robot文件?有什么作用?

时间:2021-08-02来源:网骑士

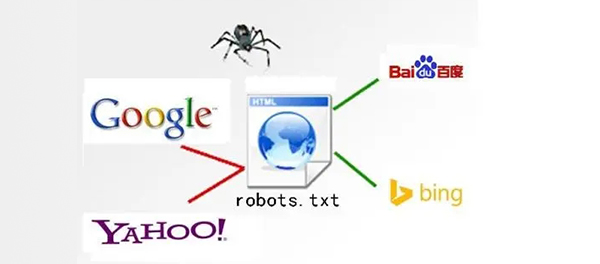

robot文件,它的作用是搜索引擎抓取程序蜘蛛,自动访问互联网上的网页并获取网页信息,如果需要限制搜索引擎抓取,也可以在robot文件中设置,限制后该搜索引擎就不会抓取网站,信息也不会被泄露,大大提高了网站后台和用户信息的安全系数。

看到这里,想必大家对robot文件有了更为深刻的认识,那么如何编辑robot文件呢?下面深圳网站建设为大家简单介绍一下robot文件的编辑规则。

第一,robots.txt首行必写User-agent,它是用于定位搜索引擎的蜘蛛类型。常见的蜘蛛类型如:谷歌蜘蛛googlebot,百度蜘蛛baidusoider,腾讯蜘蛛sosospider,搜狗蜘蛛sogouspider,360蜘蛛360spider……如果你想让所有的蜘蛛都可以来抓取那么我们可以用*来表示,意为说是有蜘蛛。

第二,robots.txt禁止抓取命令Disallow,我们可以用改命令来屏蔽抓取。常见的屏蔽操作有屏蔽js css,屏蔽动态路径,屏蔽tag标签,屏蔽低质量页面,屏蔽模板、插件文件等等,这些屏蔽内容都是为了将资源权重传递给网站参与排名的网页。

第三,robots.txt允许抓取命令Allow,其实一般情况下,如果我们吧设置允许抓取命令,那么搜索引擎蜘蛛默认就是允许抓取,所以这里我们就不再多做解释。

第四,robots.txt文件书写时还有很多需要我们注意的地方,如通配符“*”的使用,终止符“$”运用,最为重要的是,当我们书写robots.txt文件时一定要注意,我们的书写格式要定义在英文格式下,否则是不被识别的。

将robots.txt文件完成后,要将其传入我们的网站的根目录中,然后通过站长工具如,百度站长,站长之家等将robots文件进行提交检测,我们的robots文件才算正在完成。

这里还要提醒大家一下,虽然robots.txt文件有屏蔽作用,但是最好不要采取全站屏蔽,因为屏蔽是有时效的,释放也是有时效,所以全站屏蔽这种操作往往会耽误我们的网站优化。

相关资讯

-

深圳建设网站公司找哪家好随着互联网的发展,网站建设如雨后春笋般疯狂增长,在搜索引擎搜索深圳网站建设前十页...2021-08-12

-

模板建站缺点你了解多少?互联网发展至今,线上竞争越来越激烈,很多企业的思维还没转变,想着低价做个模板网站...2021-08-05

-

网站建设如何分析网站问题网站建设好后并不代表着就可以坐等客户了,网站上线后的网站SEO优化也是至关重要的...2021-08-04

-

新网站建设为什么需要加robot文件?有什么作用?robot文件,它的作用是搜索引擎抓取程序蜘蛛,自动访问互联网上的网页并获取网页...2021-08-02

-

新网站建设内部链接优化策略现在很多做网站优化都有个误区,都把精力放到了外链上,很少有人注意到内链的作用,内...2021-07-31

-

新网站建设如何更快被百度收录?有的客户刚上线隔天就被收录,有的客户上线好久一直未被收录,深圳网站建设小编曾也碰...2021-07-29

-

网站排名优化多久能出上首页经常听到SEO圈子里人说,做一个月两个月网站没排名,没咨询,没什么效果,老板给了...2021-07-28

-

深圳网站建设哪家公司性价比高深圳网站建设哪家公司性价比高?所有企业都有一个通病,就是想花几千甚至几百的价格建...2021-07-27

0755-28828820

0755-28828820 邮箱:sales@cnrider.com

邮箱:sales@cnrider.com

官网:www.cnrider.com

官网:www.cnrider.com 邮箱:sales@cnrider.com

邮箱:sales@cnrider.com  专线:18675537858

专线:18675537858